Deepfake : des vidéos à partir d'une seule photo

Zakharov et al. (2019) animent des personnes en créant des vidéos à partir d'une seule image.

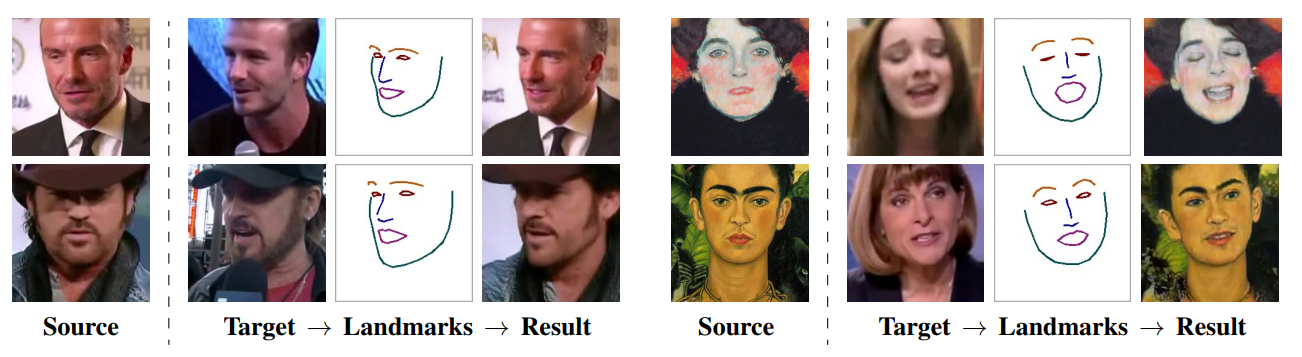

Zakharov et al. (2019), du Samsung AI Center à Moscou, ont pu créer des vidéos réalistes à partir d'une seule image, y compris si cette dernière est une peinture. Pour ce faire, ils détectent les traits principaux du visage, trouvent un modèle qui a globalement les mêmes traits, et appliquent les mouvements du modèle à l'image :1

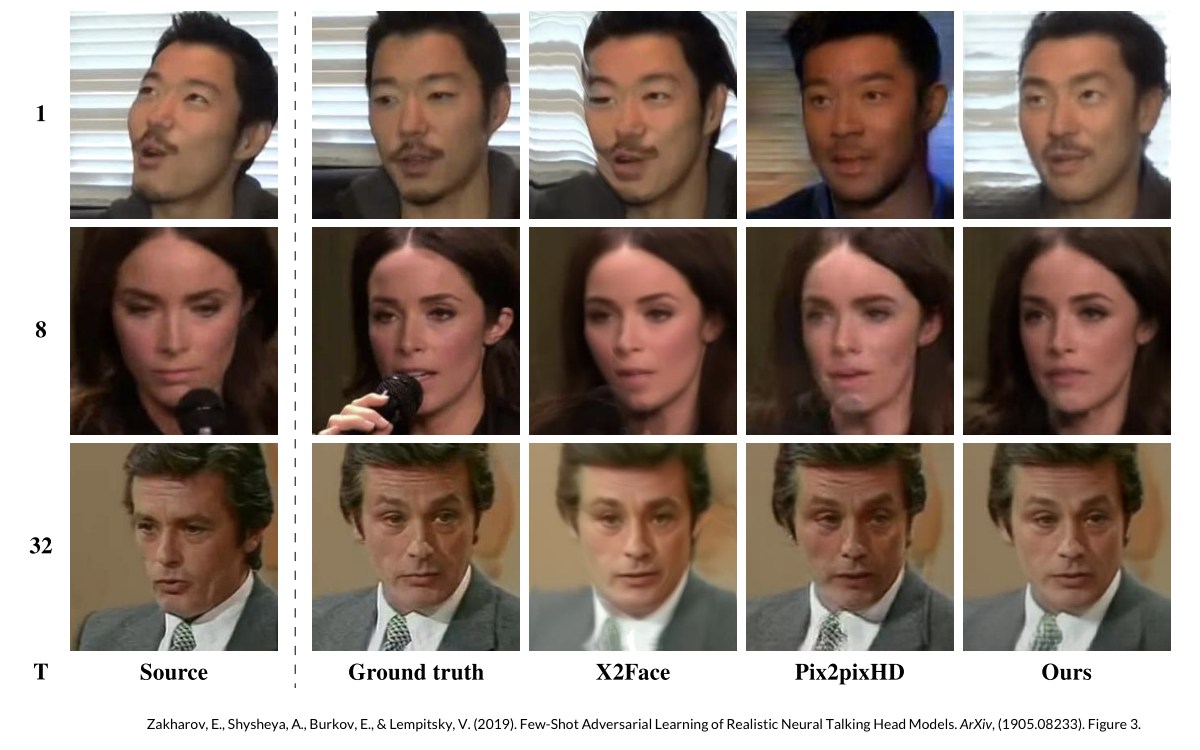

Les résultats sont nettement meilleurs que les méthodes précédentes, comme le montre la Figure 3 de l'étude2

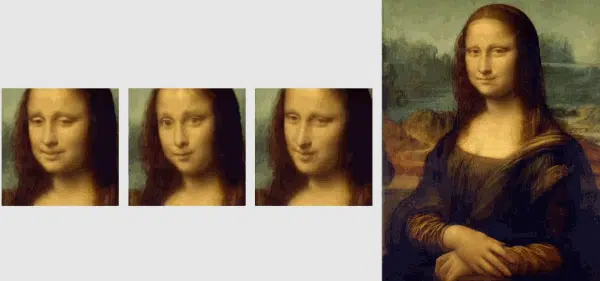

Les limites sont que la qualité dépend du nombre d'images différentes disponibles, et surtout que le résultat dépend du modèle choisi, comme le montre cet exemple sur Mona Lisa où trois modèles différents donnent trois personnalités très différentes :3

ce qui signifie que non seulement le système permet de faire dire ce qu'on veut à une personne à partir de sa simple photo, mais qu'en plus il permet de lui donner la personnalité voulue.

Cependant, Samsung affirme que d'autres utilisations que les Fake News sont envisageables et cite la téléprésence, les jeux multi-joueurs, et l'industrie des effets spéciaux.

Egor Zakharov a mis en ligne une vidéo expliquant le processus :

Ajout du 3 juin 2019

Le 3 juin 2019, Yann LeCun a partagé sur Facebook un article de Russel Brandom daté du 5 mars avec le commentaire :

DeepFake :

- pas aussi efficace que vous pourriez le pensez.

- plus facilement détectable que vous ne le pensez.

Ce qui peut expliquer pourquoi les trolls et les propagandistes ne l'ont pas beaucoup utilisé.

Référence

Zakharov, E., Shysheya, A., Burkov, E., & Lempitsky, V. (2019). Few-Shot Adversarial Learning of Realistic Neural Talking Head Models. ArXiv:1905.08233

Liens

Few-Shot Adversarial Learning of Realistic Neural Talking Head Models. Egor Zakharov. YouTube. 21 mai 2019.

A.I. can now create fake videos of people from a single picture. Paul Ratner. Big Thinks. 24 Mai 2019

Deepfake propaganda is not a real problem. Russell Brandom. The Verge. 5 mars 2019

Notes

-

Figure 1 de Zakharov et al. (2019) ↩

-

Zakharov et al. (2019, Fig 3) :

"Comparaison sur l'ensemble de données VoxCeleb1. Pour chacune des méthodes comparées, nous effectuons un apprentissage en une et quelques frames d'une vidéo d'une personne qui n'a pas été vue pendant le méta-apprentissage ou le pré-entraînement. Nous fixons le nombre de trames d'entraînement à T (colonne la plus à gauche). L'une des trames d'entraînement est affichée dans la colonne source. Les colonnes suivantes montrent l'image réelle, extraite de la partie test de la séquence vidéo, et les résultats générés par les méthodes comparées."

-

Animation crée par Big Thinks à partir de la vidéo à 5'08" ↩

©Philippe Gouillou - Dimanche 26 mai 2019